lec2-wordVec(cont.)

:material-circle-edit-outline: 约 269 个字 :material-clock-time-two-outline: 预计阅读时间 1 分钟

[02] Winter 2021 | Lecture 2 - Neural Classifiers.zh_en_哔哩哔哩_bilibili

斯坦福 NLP 名课带学详解 | CS224n 第 2 讲 - 词向量进阶(NLP 通关指南·完结 🎉) - 知乎

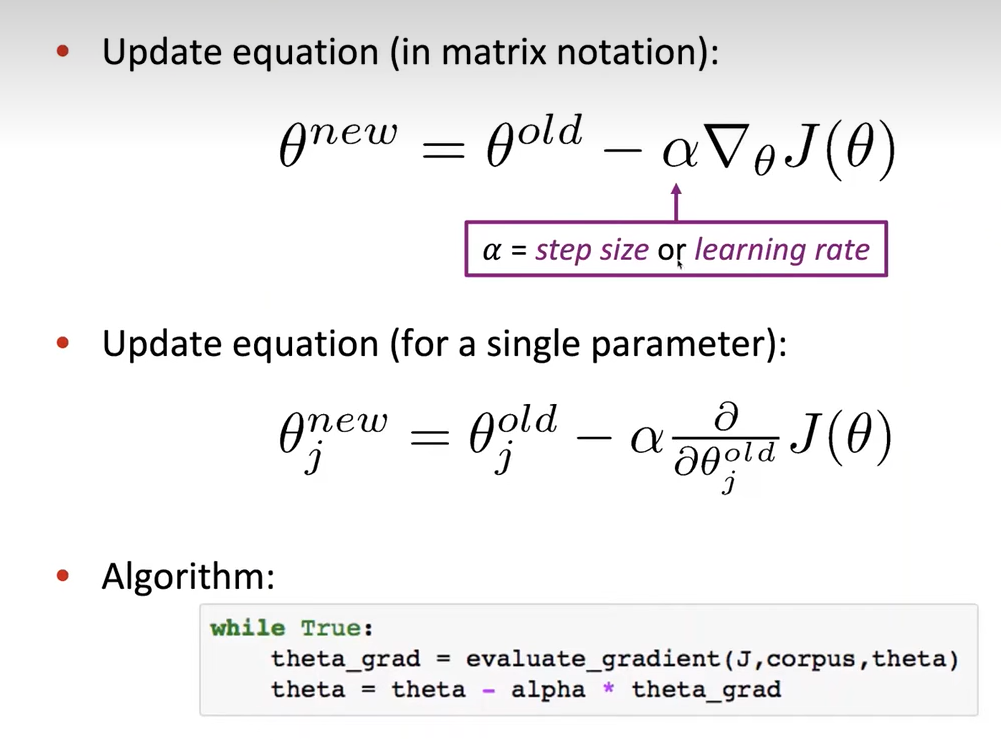

梯度下降法 Gradient Descent

最简单的梯度下降法

没有人会使用这个梯度下降法,问题在于需要对语料库的所有 C 进行求和(\(\theta\)),计算量大

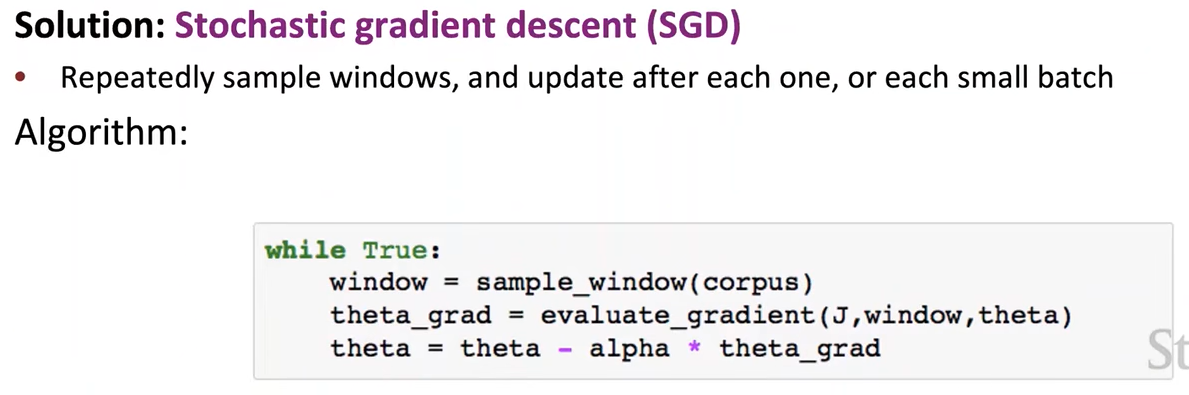

随机梯度下降法

我们改成每轮只随机抽取一小部分 C 进行梯度计算,最终效果还是很不错的

\(/\big/\big/\Big/\Bigg/\dots\Bigg\backslash\bigg\backslash\Big\backslash\big\backslash\backslash\)

共现矩阵

很大,可以用 SVD 分解缩小矩阵,但是面对大矩阵还是太慢了

GloVe

如何有效的利用 word-word co-occurrence count 并能学习到词语背后的含义?

其它

有些词词义很多,而且词义差距很大,我们可以将其分别当作独立的一个单词来处理,但更常用的还是视为一个单词,词向量则是各语义的平均值

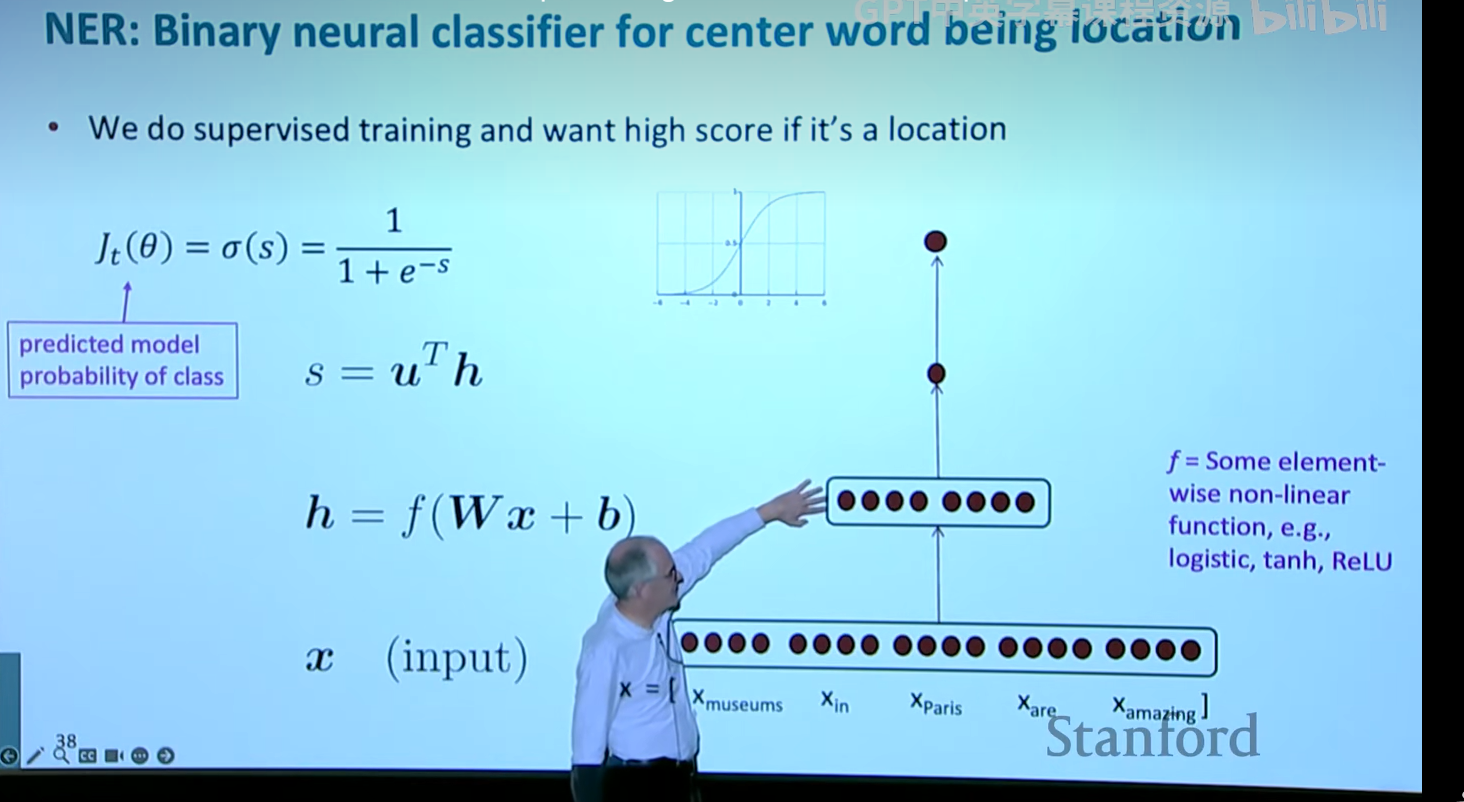

NER

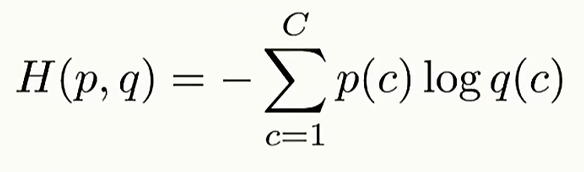

交叉熵

p 为真实概率,q 为计算概率