循环神经网络 Recurrent Neural Networks

:material-circle-edit-outline: 约 332 个字 :material-clock-time-two-outline: 预计阅读时间 1 分钟

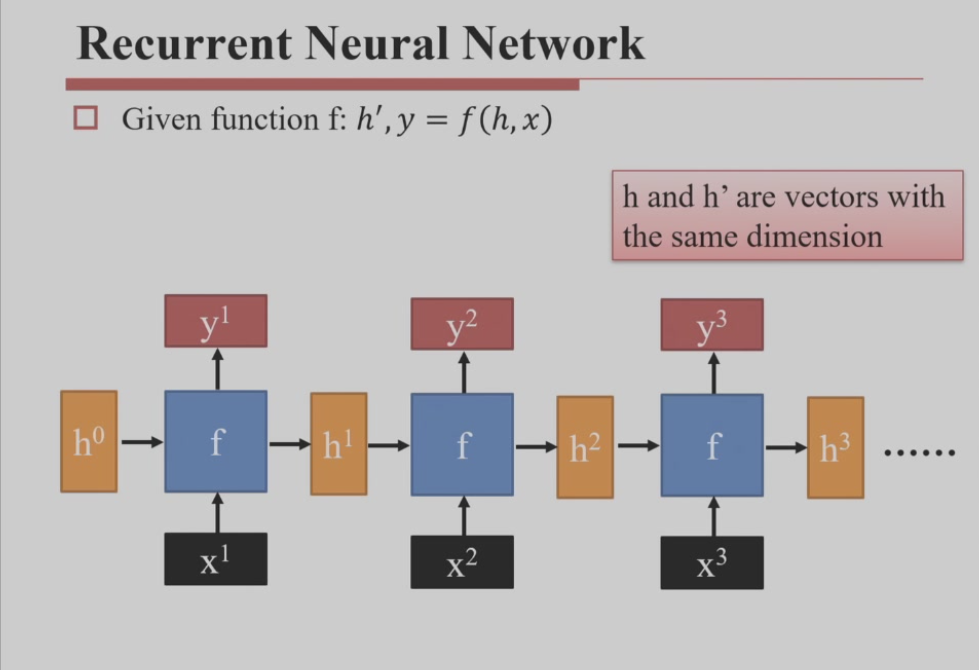

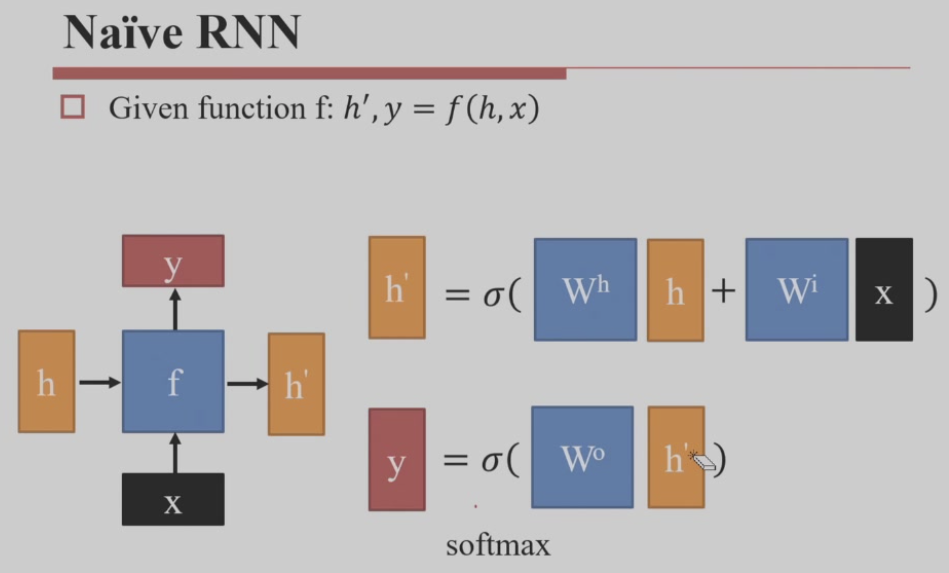

RNN

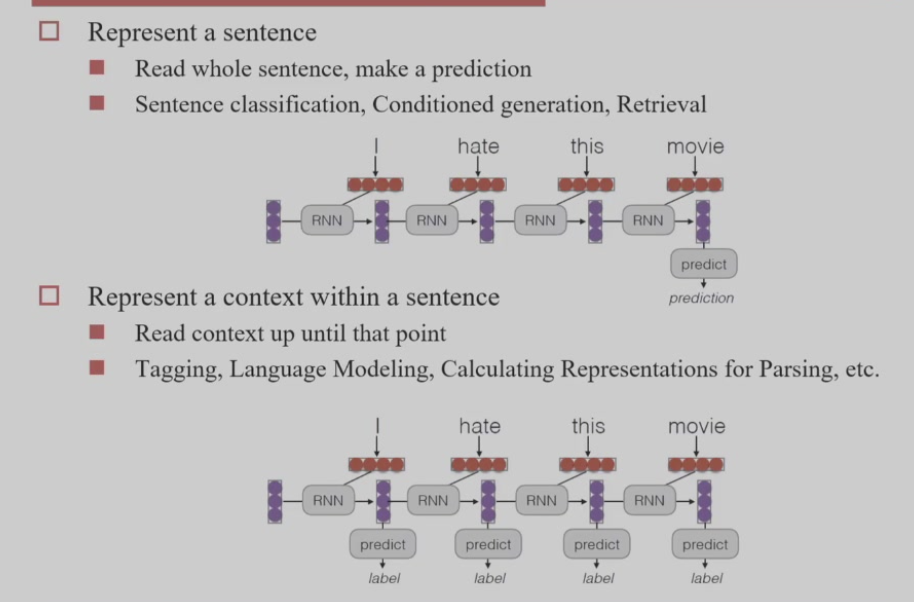

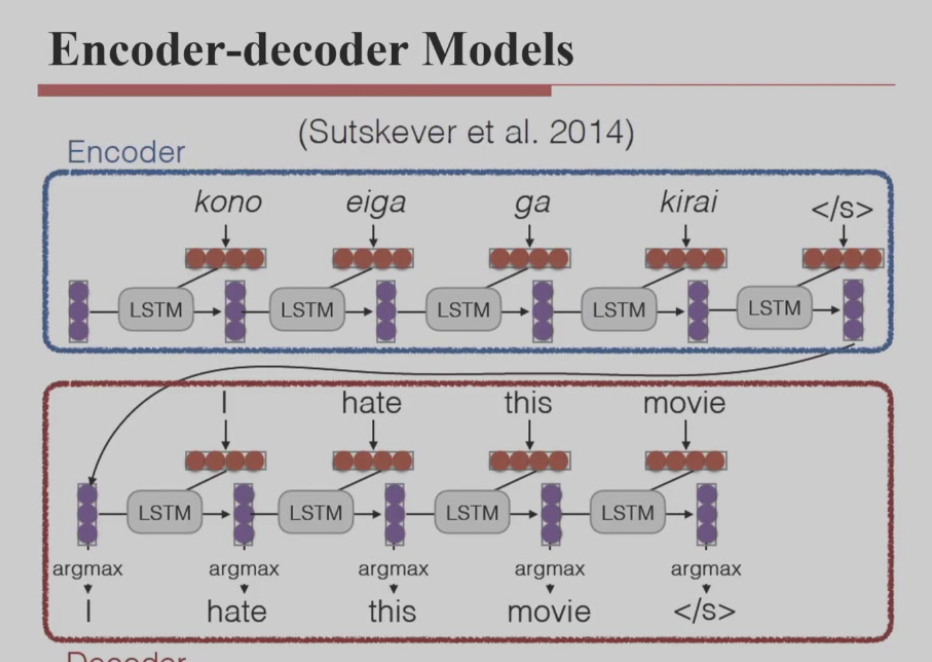

可以取最后一个输入作为整个句子的编码,这样 RNN 就是一个编码器,结合解码器就成了一个 Seq2Seq 模型

也可以指定 RNN 每个输出为下一个词,这样 RNN 就是一个文本生成器

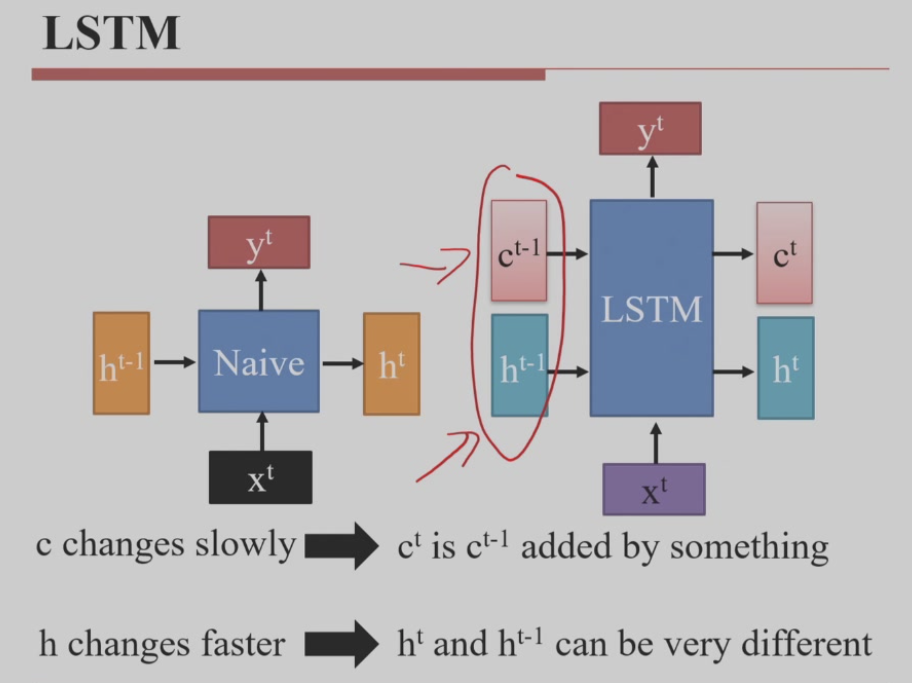

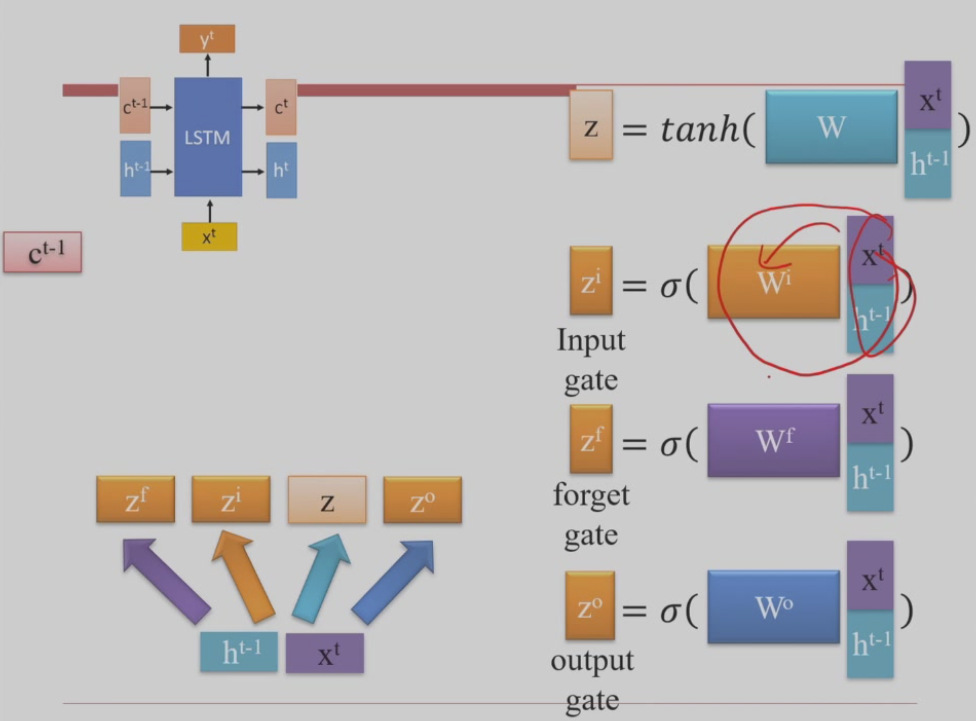

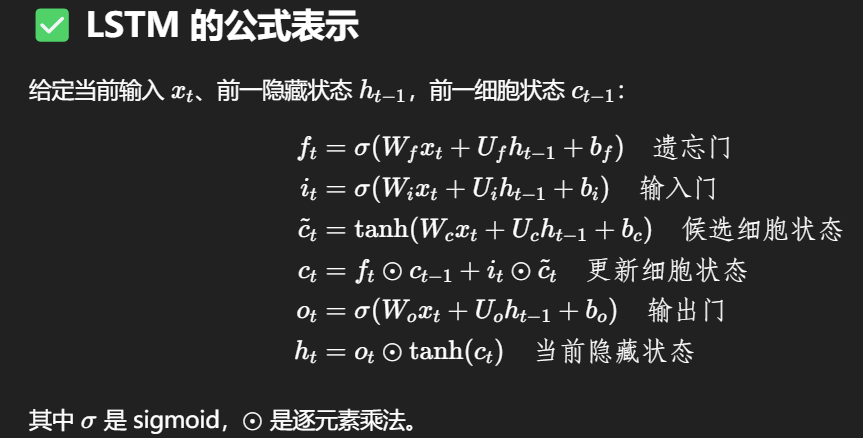

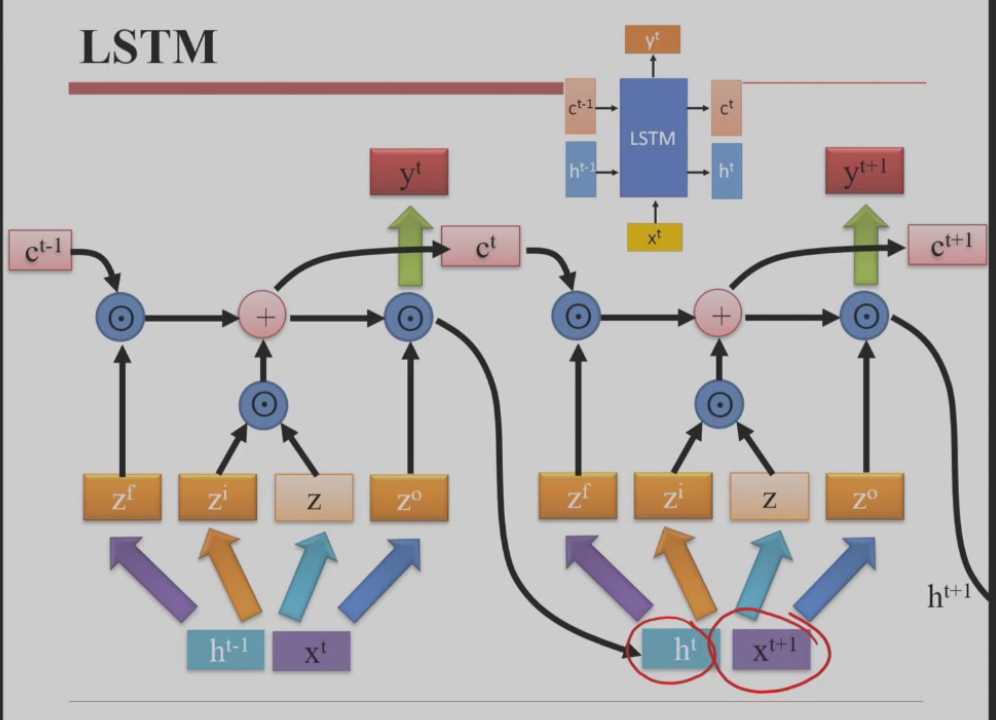

LSTM

解决记忆变化太剧烈的问题

长期记忆变化慢,用加法,短期记忆变化快,用乘法

梯度爆炸

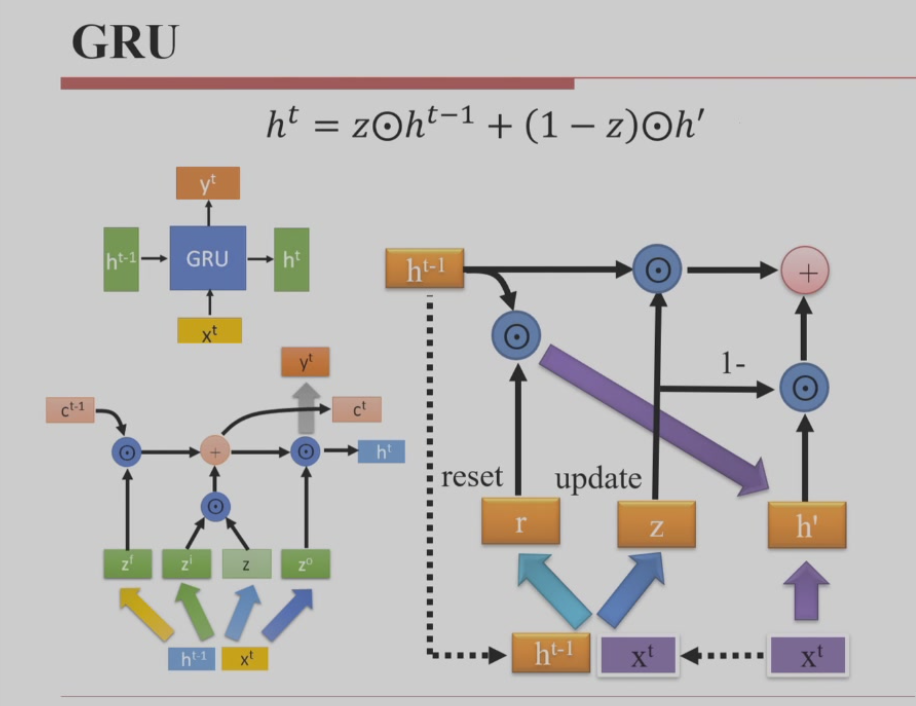

GRU

尝试解决 RNN 的记忆力不足、梯度爆炸问题

Seq2Seq

这里解码器的第一个输入的词要通过分类任务根据字典查找

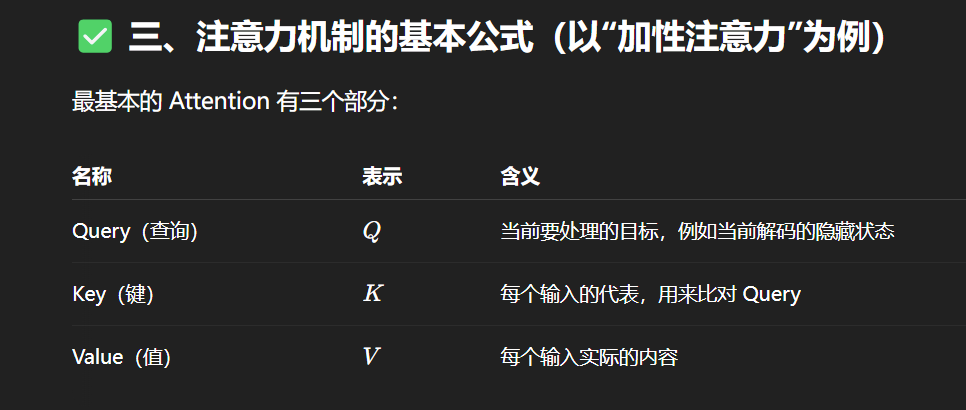

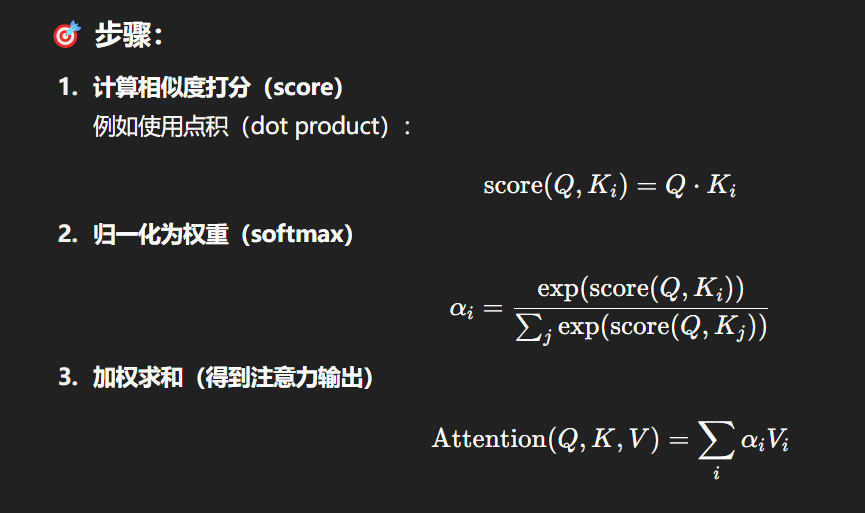

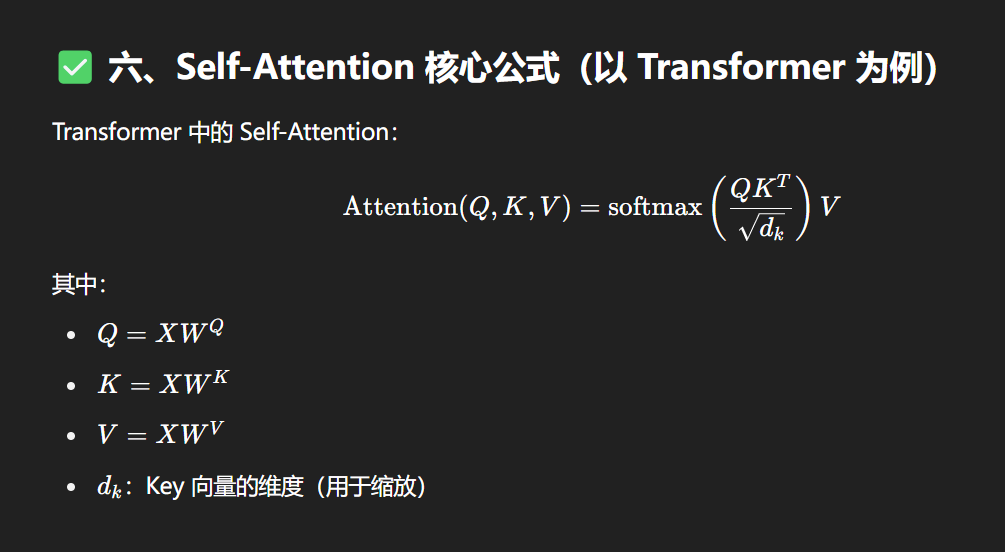

Attention

注意力机制是一种动态地为输入的不同部分分配“重要性权重”的方法,一种用权重动态选择信息的方式。它模拟人类注意力——处理信息时并不是平均分配注意力,而是专注于最相关的部分。

在传统 RNN / LSTM / GRU 中:

模型压缩了整个输入序列的信息到一个固定向量(如最后一个隐藏状态),这样容易丢失长距离依赖的信息

注意力机制的目标:让模型在生成每个输出时,可以“回头看”输入序列的所有位置,并重点关注重要的部分。